Widerlegung der Einwände gegen die Anwendbarkeit der Wahrscheinlichkeitsrechnung auf die Evolutionstheorie

- Vorbemerkungen

- Einleitung

- Analyse des Textes

- Das Protein Cytochrom c

- Die Evolution des Auges

- Das veränderte Würfelbeispiel

- Fazit

- Ergänzungen

Vorbemerkung:

Am 09.09.2002 veröffentlichte ich meine Verteidigung der Wahrscheinlichkeitsrechnung – Teil 1. In dieser Schrift analysierte ich eine Passage (Kapitel 10) des Internetdokuments Besprechung des evolutionskritischen Beitrags: „Ist der Neodarwinismus durch biologische Tatsachen zu widerlegen? Diskussion zwischen R. Kaplan und W. Lönnig“ von Herrn Martin Neukamm. Nach meiner Veröffentlichung wurde dieser von mir diskutierte Artikel von Herrn Neukamm durch einen anderen Beitrag, nämlich durch sein Internet-Dokument Evolution oder Schöpfung, Zufall oder Notwendigkeit? – die Argumentation mit der Wahrscheinlichkeit substituiert (ersetzt), den er bereits seit dem 30.04.2000 auf seiner Homepage anbietet (Einzelheiten zu dieser Vorgehensweise findet der Leser in meiner Anmerkung zu Herrn Neukamms Reaktion). Dies geschah offenbar in der Annahme, die Argumentationen in diesem Ersatzartikel seien weniger angreifbar und wissenschaftlich besser abgesichert. Dies ist jedoch nicht der Fall, wie eine Analyse in der vorliegenden Schrift zeigen soll. Ich empfehle dem Leser vor der Lektüre dieser Analyse meine Richtigstellungen (insbesondere Selektion benötigt Voraussetzungen sowie Vorstufen von Zellen), außerdem den Kritikpunkt 7, um einige grundsätzliche Intelligent-Design-Standpunkte zu kennen und zu verstehen.

Es ist eine bekannte Tatsache, dass Evolutionstheoretiker die Wahrscheinlichkeitsrechnungen von Intelligent-Design-Theoretikern nicht sonderlich schätzen und ihnen zum Teil sogar ihre Anwendbarkeit auf evolutive Mechanismen komplett absprechen. Will man der Evolutionstheorie jedoch eine halbwegs wissenschaftliche Grundlage geben, so ist man gezwungen zu erklären, wie das erste Lebewesen entstand, dass die Fähigkeit besaß, sich eigenständig zu reproduzieren. Verweist man auf irgendwelche Vorstufen, muss man im Sinn behalten, dass diese (noch) nicht lebenden Vorstufen nicht gleichzeitig fortpflanzungsfähig gewesen sein konnten, denn was sich fortpflanzt, das lebt.

Alle zum Leben notwendigen Bestandteile des ersten Lebewesens hätten somit möglichst gleichzeitig in Form von Prototypen (alle für den Stoffwechsel notwendigen Proteine (als Unikate) nebst dazugehöriger Codierung und entsprechendem „Stoff“, der „gewechselt“ werden kann, usw.) entstehen müssen, die sich irgendwie schnell zusammenfanden und zu interagieren begannen, um das erste Lebewesen entstehen zu lassen. Für dieses Szenario kann man nun gewisse Rahmenbedingungen formulieren (natürlich immer zugunsten der Evolutionstheorie!) und dann für das Auftreten dieses Ereignisses eine statistische Häufigkeit berechnen. Ist die Wahrscheinlichkeit des Auftretens auch nur eines einzigen Bestandteils (z.B.: ein ein Protein codierender DNS-Ausschnitt) bereits unter den günstigsten Bedingungen und bei einem äußerst variablen Sequenzraum, weit außerhalb des Realistischen, kann man die Aussage ableiten, dass dieses Ereignis nicht auftreten konnte. Die Annahme, ein komplettes Lebewesen mit der Fähigkeit zur Eigenreproduktion könne unter den hypothetischen Rahmenbedingungen von selbst entstehen, wäre folglich weit außerhalb des Vorstellbaren.

Zu den günstigen Bedingungen zur Bildung eines Proteins zählen zum Beispiel:

- Alle in Frage kommenden Aminosäuren sind in unbegrenzter Zahl vorhanden.

- All diese Aminosäuren sind an jedem Ort gleichzeitig verfügbar.

- Die Reaktionen laufen unter Laborbedingungen ab (z.B.: reduzierende Atmosphäre, vorhandene Energiequelle, „Ursuppe“, usw.)

Diese Voraussetzungen gelten im Grundsatz auch für die Entstehung eines DNS-Abschnitts, der ein Protein codiert.

Diese „idealen“ Voraussetzungen kann es in der Praxis niemals geben (siehe den Beitrag Ist die zufällige Entstehung informationstragender Makromoleküle möglich?). Sie werden von Evolutionstheoretikern dennoch vorausgesetzt, und zwar nur deswegen, weil selbst die Bildung von kurzkettigen Moleküle sonst bereits im Ansatz völlig unmöglich wäre – ganz zu schweigen von langkettigen Molekülen, sogenannten Makromolekülen – und Makromoleküle sind nun mal die Grundbausteine des Lebens. Diese Voraussetzungen werden also von dem erhofften Ergebnis entgegen geltenden Naturgesetzen abgeleitet. Der wissenschaftliche Weg ist hingegen genau umgekehrt: Aus bekannten Voraussetzungen werden geltenden Naturgesetzen folgend mögliche Ergebnisse abgeleitet. Lediglich innerhalb der Abstammungslehre steht das Ergebnis bereits zu Beginn als Tatsache fest: Alle Lebewesen entwickeln sich aus Vorstufen (bis auf das erste Lebewesen – das musste aus toter Materie entstehen). Nun wird über Voraussetzungen spekuliert, die dieses Ergebnis trotz gegenteiliger wissenschaftlicher Erkenntnisse und Beobachtungen möglich machen sollen. Bei einer solchen Vorgehensweise darf man das Kind auch beim Namen nennen: Dies ist offenkundig eine Vergewaltigung der Naturwissenschaft im Dienste einer Weltanschauung.

Das Gegenargument, die in Frage kommenden Mechanismen, die das erste Lebewesen entstehen ließen, seien (noch) unbekannt, wird dabei gerne und oft vorgebracht, bringt uns aber auf der Suche nach Antworten auch nicht weiter, da man mit dem Unbekannten den bekannten und beobachtbaren Tatsachen nun mal schlecht widersprechen kann, auch wenn dies innerhalb der Evolutionstheorie scheinbar gang und gäbe ist. Tatsächlich stützt sich die gesamte Evolutionstheorie auf diese unbekannten Mechanismen und folglich wird Spekulationen freier Lauf gelassen. Die Alternative, nämlich, sich auf das zu stützen, was man weiß, anstatt auf angeblich in der Zukunft noch zu machende Entdeckungen, und damit die Evolutionstheorie aufgrund fehlender Erklärungsmöglichkeiten und zahlreicher Gegenbeweise zu verwerfen oder sich zumindest etwas vorsichtiger auszudrücken, um nicht den Eindruck zu erwecken, als sei die ganze Theorie im Grunde schon so gut wie bewiesen – das entspricht nun mal nicht dem Zeitgeist.

Ich denke, dass meine Ausführungen für den Leser die grundsätzlichen Fehler der Argumentation vieler Evolutionstheoretiker deutlich aufzeigen. In diesem Sinne wünsche ich dem Leser erneut eine gewinnbringende Lektüre meiner zweiten Verteidigung der Wahrscheinlichkeitsrechnung!

Einleitung:

Ich weise im Folgenden nach, dass Herrn Neukamm in seinem Artikel folgende Fehler unterlaufen sind:

- Das Vorhandensein komplexer Strukturen wird auf molekularer Ebene als gegeben vorausgesetzt und daraus wird deren allmähliche Veränderung abgeleitet, ohne die Herkunft erster informationstragender Makromoleküle zu erklären.

- Selektion und Fixierung werden dort als Erklärung herangezogen, wo diese noch gar nicht greifen kann (siehe auch Richtigstellung: Selektion benötigt Voraussetzungen).

- Das erste Lebewesen mit der Fähigkeit der Selbst-Reproduktion wird ebenfalls als gegeben vorausgesetzt. Von diesem Lebewesen wird alles Leben abgeleitet. Wo das erste Lebewesen herkam, bleibt ungeklärt.

- Der Selektion wird vorausschauende Intelligenz unterstellt (siehe dazu Das veränderte Würfelbeispiel). Dadurch wird versucht, den Einfluss des Zufalls zu minimieren.

- Das Problem der nichtreduzierbaren Komplexität und der Synorganisation wird durch starke Verallgemeinerungen einfach übergangen (siehe Die Evolution des Auges).

Alle Absätze in Grün sind Ausführungen von Herrn Neukamm.

Analyse des Textes:

M. Neukamm: 10. Besprechung der statistischen Analyse von Klaus Wittlich und die fehlerhafte Diskussion von Wahrscheinlichkeitsbegriffen

Eine vieldiskutierte Strategie in der evolutionskritischen Diskussion besteht darin, die Möglichkeit der Entstehung von bestimmten Proteinen oder komplexen Organen aus Wahrscheinlichkeitsgründen infragezustellen. Der Evolutionsgegner bemüht dazu konkrete Beispiele von Biomolekülen oder morphologischen Strukturen, verleiht ihnen eine mathematische Präzision und weist nach, daß die Wahrscheinlichkeit für die Entstehung des fraglichen Merkmals extrem klein und damit das Auftreten des Merkmals praktisch unmöglich sei.

„Ein Bakterienmotor besteht aus fünf Funktionsgrundelementen: Die Bakteriengeisel (…) ein Winkelstück (Verbindungselement) an eine Rotationsachse gekoppelt, die von Lagern in der Cytoplasmamembran und der Zellwand der Bakterienzelle in Position gehalten wird (…) Die Rotationsachse und damit die Bakteriengeisel wird über Antriebsproteine in Rotation versetzt (…) Die Wahrscheinlichkeit, daß in einer dieser Bakterienzellen irgendwann die gewünschten (…) Mutationen zusammengekommen sind, beträgt (nach ausführlicher Berechung) 10-94.“

(JUNKER und SCHERER, 1998, S. 129 ff.)

Reinhard Junker und Siegfried Scherer (sowie andere Mitarbeiter) haben mit dem oben angeführten Buch „Evolution – Ein kritisches Lehrbuch“ eine m.E. sehr sachliche und kompetente Arbeit geliefert. Ihre Berechnungen (im Kapitel IV, Punkt 7.4 Wahrscheinlichkeit der Entstehung einer molekularen Maschine) werden von einigen Evolutionstheoretikern nicht wegen etwaiger mathematischer Rechenfehler angegriffen, sondern wegen der daraus resultierenden vernichtenden Aussagekraft. Wenn schon ein Bakterienmotor durch Mutation und Selektion nicht entstehen kann, wie sollen sich dann all die anderen Funktionen und Strukturen des Lebens mithilfe von Mutationen und Selektion gebildet haben?!

Dass die beiden Autoren den Evolutionstheoretikern (wie so oft üblich) durch eine starke Simplifizierung der Problematik (auf „nur“ 28 simultane Veränderungen) entgegengekommen sind, sollte an dieser Stelle fairerweise auch erwähnt werden.

Aber das eigentliche Problem steckt woanders: Es werden von den Autoren Junker und Scherer andere Voraussetzungen betrachtet, als es Klaus Wittlich in seiner Schrift Über die Wahrscheinlichkeit der zufälligen Entstehung brauchbarer DNA-Ketten tat. Im obigen Fall müssen nämlich bereits andere Strukturen vorhanden sein (deren Vorhandensein einfach vorausgesetzt wird), die ihrerseits aber auch irgendwie entstanden sein müssen. Aber wie? Gemäß Aussagen von Evolutionstheoretikern aus Veränderungen (Mutationen und Selektion) anderer bereits vorher bestehender Strukturen, die bis dahin das Beste darstellten, was es gab. Bereits bestehende Funktionen und Strukturen sind natürlich extrem günstigen Voraussetzung zur Entstehung neuer Funktionen und Strukturen! Diese müssen aber, wollen wir der Logik der Evolutionstheoretiker folgen, irgendwann einmal erstmals entstanden sein. Aus der Funktionslosigkeit zur ersten Funktion – das war der Schritt, den Klaus Wittlich in seinen Berechnungen betrachtete.

Dabei nahm er sich nicht etwa ein komplettes Lebewesen vor, sondern nur die Codierung eines einzigen Proteins (mit 1000 Nukleotiden) in der DNS. Zum Leben sind natürlich sehr viele Proteine/Enzyme notwendig, die teilweise weniger komplex, teilweise aber auch komplexer sind. Da sich Proteine ja nicht selbst fortpflanzen können, konnte sich eine Kette von in Frage kommenden Aminosäuren ja nicht vom Einfachen zum Komplexen in kleinen Schritten entwickeln, solange sie noch nicht Bestandteil eines Lebewesens war, sondern sie musste schlagartig da gewesen sein, um an der Entstehung des ersten fortpflanzungsfähigen Prototypen beteiligt sein zu können. Und da es in diesem ersten hypothetischen Lebewesen eben nicht nur rudimentärste Proteine gegeben haben kann (aufgrund notwendiger komplexer Funktionalitäten), müssen auch komplexe Proteine mitsamt äquivalenter Codierung entstanden sein. Proteine mit Minimalfunktionalität, wie sie immer wieder postuliert werden, könnten auch nur Minimalfunktionen ausführen. Eine Eigenreproduktion lässt sich mit rudimentärsten Proteinen wohl kaum erklären. Die Komplexität eines Proteins und dessen Interaktion mit anderen Proteinen steigt mit der Komplexität der geforderten Funktion.

Dabei ist noch nicht berücksichtigt, dass es nicht genügt, wenn die Bestandteile eines ersten rudimentären Lebewesens vorhanden sind. Mit den Einzelteilen eines Computers kann man schließlich auch nicht rechnen. Alle Bauteile des Lebens müssen zusammengesetzt worden sein, und zwar ohne Einsatz von Intelligenz, also ohne Systematik. Sie müssen alle von ihrem Entstehungsort an einen gemeinsamen Ort zusammengebracht worden sein und sich dort richtig zusammengesetzt haben. Auch die Einzelteile eines Computers werden in der ganzen Welt produziert. Und selbst, wenn sich Transistoren, Widerstände, Kondensatoren, usw. zufällig bilden könnten, würde es nichts nutzen, wenn sie nicht korrekt zusammengefügt werden. Es genügt nicht, die Einzelteile geografisch nah zusammenzubringen. Leben ist eben mehr als nur die Summe von Einzelteilen. Es ist ein funktionierendes Gesamtsystem höchster Komplexität. Klaus Wittlich wies nach, dass nicht einmal die notwendige Codierung eines einzigen Einzelteils (ein Protein) zufällig entstehen kann! Wie soll sich da ein erstes komplettes Lebewesen mitsamt Bauplan gebildet haben?

Damit die Reproduktion funktioniert, musste nämlich das auf diese Weise angeblich entstandene erste Lebewesen auch einen kompletten Bauplan von sich selbst in sich tragen, der dem Aufbau dieses Lebewesens selbst entsprach. Das wäre so, als würde ein Haus mit Sanitäranlage, Heizung, Küche, usw. durch eine Explosion auf einem Schutthügel entstehen und der Bauplan (Grundriss mit Maßangaben) entsteht durch die gleiche Explosion gleich mit. Dieser Grundriss muss aber auch genau dem zufällig entstandenen Haus entsprechen. Bis zu dieser Stelle hinkt der Vergleich mit nicht fortpflanzungsfähigen Dingen (wie Häusern) noch nicht, denn auch das erste Lebewesen muss ohne Vorstufen schlagartig von selbst entstanden sein. Erst nach der hypothetischen Entstehung eines solchen ersten Lebewesens konnte Reproduktion (die Grundvoraussetzung für Selektion) überhaupt beginnen.

Die Fähigkeit der Reproduktion ist der Schlüssel für jede angebliche weitere Entwicklung („descent with modification“). Es liegt auf der Hand, das die Eigenreproduktion eine der komplexesten Funktionen darstellt, die man sich vorstellen kann. Man stelle sich nur vor, ein Mikrochip würde tatsächlich durch Energiezufuhr in einer Art „Halbleiter-Ursuppe“ entstehen und besäße anschließend auch noch die Fähigkeit sich eigenständig zu reproduzieren, so dass es anschließend zwei identische Mikrochips gibt! Ich kann mich des Eindrucks nicht erwehren, dass Evolutionstheoretiker einen sehr viel größeren Glauben benötigen als diejenigen, die Information und komplexe Strukturen auf Intelligenz zurückführen.

Zu dem Problem des Bakterienmotors, hier noch ein kurzes Zitat von Dr. William A. Dembski:

Dr. William A. Dembski: A bacterial flagellum is a bidirectional, motor-driven propeller. Humans invented such machines before they ever knew about bacterial flagella. Such systems are independently and objectively specified. Evolution had to perform a search to attain them. Perhaps not a conscious, goal-directed search, but a search nonetheless (certainly a sampling of possibilities). Such systems require explanation, and they require explanation precisely because they are specified (even Richard Dawkins admits as much — see his Blind Watchmaker and Climbing Mount Improbable). What’s more, for Darwinists like Orr, such systems have an explanation in Darwinian terms. Any dispute about Darwinism’s ability to explain complex structures like the flagellum has nothing to do with their specification. Rather, it has everything to do with the probability of a Darwinian search being successful at finding a structure that matches the specification. That’s the question that needs to be answered. (Evolution’s Logic of Credulity: An Unfettered Response to Allen Orr, PDF-Dokument)

M. Neukamm: Entsprechend wollen LÖNNIG und WITTLICH die Unmöglichkeit der Bildung einer bestimmten DNA-Kette, bestehend aus 1000 Nukleotidbasen, nachweisen (LÖNNIG, 1991).

Nicht „entsprechend“. Junker und Scherer betrachten die Umformung einer bereits bestehenden Struktur. Klaus Wittlich dagegen deren erstmalige Entstehung.

M. Neukamm: Die Wahrscheinlichkeit der Entstehung eines solchen Gens durch statistische Polykondensation wird (unter Berücksichtigung einer „erlaubten“ Abweichung von 40%) zu 5 * 10-290 berechnet, die Entstehung damit natürlich völlig unwahrscheinlich gemacht.

Ich fürchte, Herr Neukamm wirft hier einiges durcheinander. Die Wahrscheinlichkeit der Entstehung der Codierung eines Proteins mit 1000 Nucleotiden beträgt 1 : 1,15 · 10602. Wenn die Codierungssequenz bis zu 40% abweichen darf, dann beträgt die Wahrscheinlichkeit der Entstehung dieser Codierung 1 : 2,6 · 10120. Um zu verdeutlichen, was das bedeutet, möchte ich die Zahl nun einmal ausschreiben: Man hätte bei diesen Rahmenbedingungen rund 4 415 887 289 516 363 554 741 666 158 375 700 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 verschiedene Codierungsmöglichkeiten für ein und dasselbe Protein. Wie jeder erkennen kann, ist Klaus Wittlich den Evolutionstheoretikern hier sehr weit entgegen gekommen. Die Zahl von der Herr Neukamm spricht, ist die Anzahl der Varianten bei einer Sequenzvariabilität von genau 40% Abweichung. (Und dabei hat er noch die Potenzregeln umgangen. Will man nämlich aus 5 · 10290 den Kehrwert bilden, so kann man nicht einfach 5 · 10-290 schreiben. Statt dessen ist das Ergebnis 2 · 10-291. Die Mathematik steckt eben voller Geheimnisse :)).

Im Übrigen wird dadurch die Entstehung nicht völlig unwahrscheinlich „gemacht„, sie ist völlig unwahrscheinlich!

M. Neukamm: Entsprechend lesen wir auf LÖNNIGs Homepage an anderer Stelle:

„(Es) ist bewiesen worden, dass die evolutive Entstehung völlig neuer, ganz spezifischer Funktionsproteine außerhalb des Bereichs der Wahrscheinlichkeit der sich auf unserer Erde abspielenden Zufallsprozesse liegt (…)“

Eine ausführliche Abhandlung, warum langkettige informationstragende Moleküle nicht von selbst entstehen können, findet der Leser auf der Seite: Ist die zufällige Entstehung informationstragender Makromoleküle möglich?.

M. Neukamm: Nun haben jedoch seit Generationen Wissenschaftler, wie zum Beispiel von DITFURTH, DOSE und RAUCHFUSS, MAHNER, SCHUSTER, VOLLMER und viele andere vorgerechnet und erklärt, weshalb solche und ähnliche Schlußfolgerungen völlig falsch sind. Tatsächlich wird in einer Weise multipliziert und potenziert, daß darüber die Voraussetzungen vergessen werden, unter denen solche Schlüsse berechtigt wären (MAHNER, 1986).

Zunächst ist festzuhalten, daß die Evolution nicht ein konkretes Biomolekül zu verwirklichen braucht, um eine bestimmte Funktion zu realisieren. Vergleichende Untersuchungen zeigen, daß viele verschiedene Nucleotid- oder Aminosäuresequenzen zu Nucleinsäure- oder Proteinstrukturen mit praktisch denselben Eigenschaften führen.

Richtig. Deshalb ging Klaus Wittlich ja auch, wie bereits erwähnt, von 4 415 887 289 516 363 554 741 666 158 375 700 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 000 verschiedenen Aminosäuresequenzen (bzw. deren Codierung) aus. Dennoch ist die Entstehung eines Proteins (bzw. dessen Codierung) aus mathematischer Sicht deswegen nicht spürbar wahrscheinlicher geworden.

M. Neukamm: Die erfolgversprechenden Strukturen kommen nun nicht gehäuft in einer bestimmten Zone des Sequenzraumes vor (so wie etwa die Varianten eines bestimmten Enzym-Typs), sondern sind mehr oder minder regellos verteilt. Dies bedeutet, daß von jeder beliebigen Sequenz ausgehend in einigen Schritten eine erfolgversprechende Struktur realisiert werden kann.

Erst einmal muss irgendeine Sequenz entstehen! Hier wird der Fall betrachtet, wenn das Leben bereits vorhanden ist, Enzyme von dem Lebewesen gebildet werden und das dafür notwendige Codierungs-Molekül dann mutiert. Warum sollte aber die Codierung eines Enzyms entstehen, wenn noch gar kein Leben da ist? Welchen Zweck sollte es haben? Dienen Enzyme nicht der Aufrechterhaltung des Lebens? Wozu sollen Proteine gut gewesen sein, bevor das erste Lebewesen existierte? Woran misst man Erfolg, wenn es keine Aufgabe gibt? Was sollte es für einen Sinn haben, wenn auf einem toten Planeten irgendwo plötzlich (zumindest für einige Sekunden) die DNS-Information für ein funktionales Protein vorhanden ist? Wer würde sich dafür interessieren? Weder ein Enzym noch dessen Codierung existiert zum Selbstzweck! Außerdem kann beides der Entropie nicht dauerhaft standhalten und würde in kurzer Zeit zerfallen.

M. Neukamm: So konnte SCHUSTER mathematisch nachweisen, daß „alle wesentlichen Sekundärstrukturen von Sequenzen aus 100 Nucleotiden durch maximal 20 Nucleotidsubstitutionen von jeder Zufallssequenz aus zu erreichen (sind).“ Dieser Umstand macht schon deutlich, daß wahrscheinlichkeitstheoretische Berechnungen, die solche Voraussetzungen außer Acht lassen, bedeutungslos werden (SCHUSTER, 1994, S. 63).

Wo kommen die „Sekundärstrukturen von Sequenzen aus 100 Nucleotiden“ her? Es geht nicht um Veränderung einer bestehenden Struktur, sondern um die Entstehung derselben!

M. Neukamm: Desweiteren erfolgt der Austausch von Aminosäuren (oder Nucleotidbasen) gegen andere gar nicht völlig regellos und zufällig, wie Wahrscheinlichkeitsberechnungen unterstellen: Aminosäuren werden bevorzugt durch bestimmte andere substituiert; ein isopolarer Austausch von Aminosäuren erfolgt häufiger als ein heteropolarer. Auch die abiotische Bildung von Proteinoiden durch Verkettung von Aminosäuren verläuft nach thermodynamischen und reaktionskinetischen Regeln. Die Aminosäuresequenzen werden durch die chemischen Eigenschaften der Aminosäuren selbst sowie durch die Reaktionsbedingungen beeinflußt (FOX, 1965). Alpha-Peptidbindungen bilden sich bevorzugt und die Mengenausbeute bestimmter Polypeptide ist höher als bei statistischer Zufallsverteilung (REINBOTHE und KRAUSS, 1982, S 190 ff.).

Der Begriff „substituiert“ setzt das Vorhandensein bestehender Proteine voraus. Aber wie sind die für ein erstes Lebewesen notwendigen Proteine erstmals entstanden?

In der deutschen Sprache existieren bestimmte Buchstabenfolgen nicht (zum Beispiel: „qk“ oder „yy“), andere kommen jedoch ständig vor (zum Beispiel „ch“ oder „ei“). In Anlehnung an obiges Zitat, müsste der Satz heißen: „Die Mengenausbeute bestimmter [Buchstabenkombinationen] ist höher als bei statistischer Zufallsverteilung“. Eine Erklärung für die Entstehung eines Romans ist das nicht.

M. Neukamm: Ein ausgezeichnetes, von Evolutionsgegnern verkanntes Prinzip zur Eindämmung der kombinatorischen Vielfalt besteht schließlich im stufenweisen Aufbau „modularer Strukturen„. Im Falle von Biomolekülen handelt es sich um mehr oder minder autonome Faltungseinheiten, die brauchbare Strukturmerkmale aufweisen. Große Proteine besitzen in der Regel mehrere solcher hierarchisch strukturierten Module. Diese müssen nun nach GILBERT nicht alle gleichzeitig entstanden sein, denn es hätte bereits genügt, wenn aus der Vielfalt aller möglichen Sequenzen zunächst eine beschränkte Anzahl von autonomen Modulen aufgebaut wurde, die jeweils nur einen Bruchteil der Kettenlänge umfassen.

Hämoglobin ist beispielsweise aus zwei identischen Modulen aufgebaut. Dennoch würden sie ja nach einer bereits unmöglichen zufälligen Bildung wieder zerfallen. Obige theoretische Überlegung geht wieder von bereits vorhandenen Lebewesen aus. Ein komplettes Lebewesen muss aber, damit es überhaupt leben kann, alle für das Leben notwendigen Bestandteile besitzen. Diese müssen zwangsläufig gleichzeitig am gleichen Ort entstanden sein und sich korrekt zusammengefügt haben. Ob ein solches „Lebewesen“ dann auch lebt, ist dann noch eine ganz andere Frage.

M. Neukamm: Jene Module, die in irgendeiner Weise brauchbare Strukturmerkmale aufweisen, könnten auf dieser Stufe durch Selektion fixiert werden, so daß durch schrittweise Kombination selektionspositiver Module komplizierte Biomoleküle mit eventuell neuen Eigenschaften entstehen. Die Hypothese der Kettenverlängerung durch „exon-shuffling“ macht deutlich, daß der Zufall infolge von Selektion nur noch eine geringe Rolle im evolutionären Aufbau größerer Proteine spielt (GILBERT, 1978).

Herr Neukamm spricht wiederholt von „Selektion“ oder ’selektionspositiven Modulen‘. Es kann aber keine Selektion und Fixierung ohne Reproduktionsfähigkeit geben! Bei der „Exon-shuffling“-Hypothese geht man ebenfalls von bereits existierenden Lebewesen aus. Die Entstehung eines DNS-Moleküls oder eines Proteins mithilfe der Aneinanderkettung einzelner Untersequenzen kann bei der Entstehung der ersten informationstragenden Struktur natürlich nicht funktionieren, denn dazu benötigt man einen ungestoppten Nachschub an bereits informationstragenden DNS-Sequenz-Fragmenten. Diese Fragmente sollen angeblich jeweils eine bestimmte Funktion codieren. Durch Aneinanderreihung sollen dann neue komplexere Funktionen entstehen. Ein Problem in Teilprobleme (Module) zu zerlegen, löst das Problem aber nicht für die Erstentstehung einer informationstragenden Struktur.

Warum Exon-shuffling bei der Erstentstehung eines informationstragenden Moleküls keinen Vorteil bringt, finden Sie unter Richtigstellung: Die Entstehung erster informationstragender DNS-Sequenzen mithilfe von exon-shuffling.

Der Ausdruck „durch Selektion fixiert“ ist an dieser Stelle unberechtigt, denn ohne die Fähigkeit der Vermehrung kann es keine Selektion geben, folglich kann auch nichts fixiert werden. Zudem ist der Begriff „autonom“ irreführend. Auch ein Stein ist autonom, aber eben nicht fortpflanzungsfähig. Das ist eine Aminosäuresequenz auch nicht.

Das Protein Cytochrom c

M. Neukamm: Zu den Paradebeispielen in dieser Frage zählt das Cytochrom c, ein Enzym, das aus etwa 104 Aminosäuren besteht und in der Atmungskette eine wichtige Funktion übernimmt. Evolutionsgegner rechnen nun vor, daß die Wahrscheinlichkeit, das Enzym durch Zufall zu erhalten, bei 20 verschiedenen Aminosäuren 20-104, also „fast Null“ beträgt. Zunächst muß aber berücksichtigt werden, daß nur 34 der 104 Aminosäuren das aktive Zentrum des Enzyms bilden, das für die katalytische Funktion des Enzyms verantwortlich ist; die restlichen Aminosäuren sind weitgehend frei wählbar. Desweiteren wird verkannt, daß das Protein nicht von Beginn an seine spezielle und optimale Funktion, die es heute einnimmt, zu besitzen brauchte. Es hätte ja schon genügt, wenn das Enzym irgendeine Funktion als Elektronenüberträger (oder eine beliebige andere Funktion) besaß, die den Organismen einen Überlebensvorteil bot. In Anlehnung an SCHUSTER ist auch nur ein winziger Ausschnitt des Sequenzraumes zu „durchsuchen“, um solch eine funktionelle Struktur zu finden. Überdies hätte es seine heutige Funktion auch später durch Kettenverlängerung („exon-shuffling“) oder durch entsprechende funktionsverändernde Mutationen erreichen können (KESSLER in: SIEWING (Hrsg.), 1982). Unter Berücksichtigung solcher Faktoren wurde gezeigt, daß die Bildung des Cytochrom c recht wahrscheinlich ist (DOSE und RAUCHFUSS, 1975, S. 185 f.; MAHNER, 1986).

Cytochrom c weiß nichts von einem „Überlebensvorteil“, da dieses Enzym nicht lebt. Es führt vielmehr eine Funktion in einem Lebewesen aus. Es ‚übernimmt eine wichtige Funktion in der Atmungskette‘ und wäre ohne einen zum Stoffwechsel fähigen Organismus nutzlos. Es muss von einem Lebewesen hergestellt und geschützt werden. Das ist der einzige Grund, warum Enzyme überhaupt existieren. Sie dienen der Aufrechterhaltung des Lebens, erklären aber nicht dessen Entstehung. Sie sind die Voraussetzung für Leben, aber nicht dessen Erklärung. So wie Silicium eine Voraussetzung zur Herstellung von Computerchips ist, aber das Vorhandensein von Silicium nicht die Existenz von Computerchips erklärt. Die Frage ist demnach: „Wie entstand ein Enzym wie Cytochrom c?“ und nicht: „Wie könnte aus einem Enzym wie Cytochrom c im Laufe der Zeit ein Adler oder ein Wildschwein entstehen?“.

M. Neukamm: Die Nichtbeachtung biochemischer Voraussetzungen sowie der Selektion zeigen also, wie schnell irrelevante Wahrscheinlichkeitsaussagen über die Biogenese gemacht werden.

An der Nichtbeachtung der Selektion kommt man nicht vorbei, da Selektion ja keinen Einfluss auf die Entstehung des ersten Lebewesens mit der Fähigkeit der Eigenreproduktion haben kann. Biochemische Voraussetzungen erhöhen die Wahrscheinlichkeiten nicht, sie stellen die Entstehung langkettiger Moleküle sogar grundsätzlich in Frage. Einzelheiten findet man in meinem Beitrag: Ist die zufällige Entstehung informationstragender Makromoleküle möglich?.

Der folgende Abschnitt beschäftigt sich wieder mit – Sie ahnen es bereits – Selektion.

M. Neukamm: Gleiches gilt auch in der Diskussion um „Makroevolution„, also in der Frage der Entstehung komplizierter Strukturen, wie etwa dem eingangs erwähnten Bakterienmotor. Zunächst ist augenfällig, daß in der „Makroevolution“ beständig von „Zufallsevolution“ gesprochen wird (LÖNNIG, 1989). Ein illustratives Beispiel, wie schnell der richtende Faktor der Selektion aus den evolutionären Betrachtungen verschwindet, gibt BLEULER in der Frage der Evolution des Wirbeltierauges:

„[Wenn jeweils] zufällige Variation die Ursache war, so mußten entstehen 1. eine nervöse Retina, 2. das Pigment, das irgendwie die Übertragung des Lichtreizes auf die Nervenenden ermöglicht oder sonst eine notwendige Rolle spielt, 3. eine durchsichtige und optisch glatte Haut, 4. eine Konvexlinse, 5. ein durchsichtiger Körper, der die notwendige Distanz zwischen Linse und Retina ausfüllt, 6. eventuell ein Schutzorgan (…) Nun müssen die Organe aber in bestimmter Reihenfolge hintereinander liegen (…) Die Cornea darf natürlich nur an der vorderen Oberfläche liegen, und auch daselbst sind nur eine oder ganz wenige Stellen geeignet (…) Die drei optischen Organe, Cornea, Linse und Glaskörper, müssen außerdem sehr gut zentriert sein (…) Die Zentrierung muß aber auch winkelrecht sein (…) Auch Augenlid und Retina können nur um einen Bruchteil ihrer Größe abweichen, so daß der Nenner noch um einige Stellen zu vermehren wäre (…) Es ist leicht abzusehen, daß solche Umstände die Wahrscheinlichkeit eines Zufalls auf unendlich nahe an Null herabsetzen.“ (BLEULER, zitiert nach LÖNNIG, 1989)

Dem interessierten Leser empfehle ich wärmstens die hier zitierte Schrift, die vollständig im Internet veröffentlicht wurde: Auge widerlegt Zufalls-Evolution.

M. Neukamm: Wollten wir aber eine Beispielrechnung anführen, die mit Evolution noch irgend etwas zu tun haben soll, müßte die Art und Weise, wie in der Evolution Funktionalität entsteht, völlig anders besprochen werden: Zunächst muß darauf hingewiesen werden, daß komplexe Strukturen nicht „fix und fertig“ in einem Schritt „zusammengewürfelt“ werden, wie dies BLEULER suggeriert, sondern schrittweise über selektionierte Zwischenstufen entstehen.

Falsch! Komplexe Strukturen müssen irgendwann erstmals entstanden sein – eben zu der Zeit, als noch keine Reproduktionsfunktion existierte. Schrittweise Entstehungen erhöhen nicht die Wahrscheinlichkeit, sondern bergen die Gefahr in sich, dass ein sich dahinschleppender Aufbau von Strukturen (deren Aufbau nicht mit Naturgesetzen erklärt werden kann) abgebrochen wird und die halbfertigen Strukturen wieder zerfallen, bevor sie überhaupt fertig sind. Je länger der Aufbau dauert, um so ungünstiger ist das für das Protein, das dem permanenten Zerfall ausgesetzt ist. Das erste Protein, dass hinterher im vermeintlichen ersten Lebewesen mit Reproduktionsfunktion seine Funktion ausübt, muss „fix und fertig“ „zusammengewürfelt“ werden – und das möglichst schnell. Daran führt kein Weg vorbei!

M. Neukamm: Die Evolutionskritiker weisen zwar auf die „nichtreduzierbare Komplexität“ von Organen hin, das heißt, man benennt „fertige“ Strukturen, die sich aus mehreren Komponenten zusammensetzen und weist nach, daß das Fehlen eines Strukturelements zum Versagen der Organfunktion führt. Daraus wird dann der Schluß gezogen, daß ein Selektionsvorteil nur im fertig ausgebildeten Zustand gegeben sei, womit die evolutionäre Schlüsselrolle der Selektion untergraben wäre (JUNKER und SCHERER, 1998, S. 81).

Das ist e i n Grund, warum Selektion nicht funktioniert. Der zweite ist, dass bei der Entstehung des allerersten Lebewesens Selektion nicht greifen kann.

M. Neukamm: VOLLMER hat jedoch gezeigt, daß solche Voraussetzungen nur dann richtig wären, wenn jedes Teilorgan von Beginn an seine Funktion besaß, die ihm auch im fertigen Organ zukommt. Dies ist jedoch, wie sich zeigt, nicht der Fall.

Evolution führt meist zu Funktionsänderung, das heißt, Teilstrukturen können auch in einem völligen anderen Funktions-Zusammenhang ihren Nutzen gehabt und daher „präadaptiert“ sein. Deshalb können komplexe Funktionseinheiten auch dann schrittweise entstehen, wenn die tragende Rolle von Doppelfunktionen und Funktionsänderung in der Evolutionsbiologie berücksichtigt wird. Dazu zwei Beispiele:

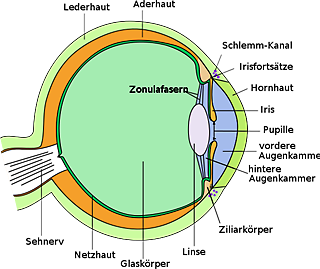

Die Evolution des Auges

M. Neukamm: Das „Becherauge“ einer Schnecke braucht weder einen Glaskörper, noch eine Linse oder eine Hornhaut, geschweige denn ein Augenlid oder gar ein kompliziertes Sehzentrum, um zu funktionieren, denn seine Funktion bestand zunächst lediglich darin, dem Weichtier das Richtungssehen zu ermöglichen.

Niemand behauptet, ein hochkomplexes Becherauge hätte völlig fertig auf einen Schlag entstehen müssen, denn das wäre ja „reduzierbare Komplexität“. Intelligent-Design-Theoretiker betrachten den nicht mehr weiter simplifizierbaren Fall des primitivsten Auges, dass man noch als Auge bezeichnen könnte, und lediglich eine Minimal-Seh-Funktion liefert. Das ist „nichtreduzierbare Komplexität“! Alle für ein solches Auge notwendigen Bestandteile müssen gleichzeitig vorhanden gewesen sein und mussten korrekt interagieren können (Synorganisationsproblem), damit Selektion nicht zerstörerisch wirkt. Entsteht nur ein Bestandteil, würde dieser als überflüssig erkannt und ausselektiert. Doppelfunktionen sind abgesehen von ihrem spekulativen Charakter keine Erklärung der gleichzeitigen Verschonung jeweils alle Bestandteile aller Organe aller Lebewesen vor der unbarmherzigen Selektion. Auch kann nicht jede hypothetische Verbesserung in kleinen Schritten erfolgt sein, da selbst Strukturen mit vorher anderen Funktionen (eben Doppelfunktionen) ihre Funktionalität schlagartig hätten verändern (oder erweitern) müssen, als sich synorganisierte Strukturen spontan bildeten oder andere Funktionen ihre bisherige Funktion aufgaben oder mehrere Funktionen gleichzeitig auszuführen in der Lage waren, um fortan neue Aufgaben zu erfüllen. Es mussten auf jeden Fall sehr viele Änderungen gleichzeitig stattgefunden haben, damit sich neue Fähigkeiten oder neue komplexe Strukturen bilden konnten, ohne dass die veränderungshemmende (und damit evolutionsfeindliche) Selektion einen Strich durch die Rechnung machen konnte. Auch Doppelfunktionen unterliegen dem Synorganisationsproblem und sind in der Häufigkeit ihres Auftretens natürlich wesentlich seltener als Organbestandteile mit Einfachfunktionen. In der Regel haben Organbestandteile sogar nur im Zusammenspiel mit anderen Bestandteilen und innerhalb eines kompletten Organs eine Funktion. Ohne dieses Zusammenspiel sind sie ohnehin funktionslos.

Den gleichen Ansatz verfolgen Junker und Scherer mit dem Bakterienmotor. Sie verringern die Komplexität eines solchen Motors, bis sie nicht weiter reduzierbar ist. Selektion scheidet in diesem Fall aus und alles hängt von der Mutation ab, die dem Zufall unterworfen ist. Und damit ist die Grundlage geschaffen, die Stochastik zur Berechnung von Wahrscheinlichkeiten heranzuziehen.

Ich möchte den Leser den folgenden Absatz nicht vorenthalten. Er ist ein wahrer Genuss, zu lesen, wie einfach die Evolution des Auges ablieft:

M. Neukamm: Eine günstige Anpassung vergrößerte aus Schutzgründen die Vertiefung immer mehr und schloß das Becherauge bis auf eine kleine Lichtöffnung.

Eine Vertiefung und ein Verschluss haben eine permanente Verschlechterung der Lichtausbeute zur Folge. Mit jedem Schritt kann das Lebewesen schlechter zwischen hell und dunkel unterscheiden. Die Selektion wird immer dann von Evolutionstheoretikern solange „deaktiviert“, bis sich am Ende einer Kette von Veränderungen ein größerer Vorteil ergibt als die Summe der einzelnen Nachteile. Hier wird der Selektion einfach vorausschauende Intelligenz unterstellt! Die erwähnte unbekannte „günstige“ Anpassung besteht also aus einer Reihe von nachteiligen Veränderungen, die aber im Endergebnis Vorteile bringen soll. Am Ende der Kette wird die Selektion dann wieder zum Zwecke der Überprüfung des Endergebnisses „rekrutiert“.

So kennt man es ja auch, wenn man sein Auto mal zur Reparatur bringt. Da wird beispielsweise der Vergaser durch einen neuen, besseren ausgetauscht, sowie die Bremsbeläge und die Zündkerzen durch die jeweils neusten Modelle. Wer wollte leugnen, dass diese Veränderungen eine Verbesserung für das Fahrzeug darstellen. Diesen Austausch kann man natürlich nicht während der Fahrt vornehmen, denn vorübergehend ist der Austauschprozess für das Fahrzeug so nachteilig, dass es nicht mehr fahrtauglich ist, und zwar so lange, bis alle Teile wieder korrekt eingebaut wurden. Oder anders ausgedrückt: Wer ohne Bremsen fährt, wird sehr schnell ausselektiert. Ein Lebewesen kann natürlich während so einer Umbauphase sein Leben nicht einfach vorübergehend einstellen oder sich anderweitig vor der Selektion in Sicherheit bringen.

M. Neukamm: Es war nun eine Doppelfunktion, die den glücklichen Umstand fügte, daß sich so nebenbei ein Organ bildete, das erstmals neben dem „Richtungs- und Bewegungssehen“ ein scharfes Abbild der Umwelt lieferte: [Unterstreichungen von mir]

Zum scharfen Sehen gehört mehr als eine möglichst kleine Öffnung (Blende). Der Hauptfaktor liegt in einer hohen Anzahl von einzelnen Photorezeptoren und angeschlossenen Sehnerven. Diese müssten sich also zeitgleich mit einer kleinen Blendöffnung entwickelt haben, damit diese überhaupt einen Sinn gemacht hätte. Dann muss sich ein entsprechend komplexes Sehzentrum im zentralen Nervensystem gebildet haben, dass in der Lage ist, die einzelnen Lichtsinnesreize zu einem gesamten Bild zusammenzufügen, dass von dem Lebewesen auch interpretiert werden kann. Ganz unberücksichtigt bleibt dabei, dass das Bild bei einem Linsenauge natürlich auf dem Kopf steht und erst in einem (sich auch gleichzeitig entwickelten) den Anforderungen angepassten Sehzentrum gedreht werden musste (eine komplexe Funktionalität in einem programmierbaren Nervensystem). Das ist ein Beispiel für das Problem der Synorganisation und der nichtreduzierbaren Komplexität! All das muss gleichzeitig entstanden sein, damit das neue System funktioniert. Es würden sich niemals mehrere Lichtrezeptoren bilden, wenn diese nicht an ein Sehzentrum angeschlossen wären, bzw. dieses Sehzentrum noch gar nicht existieren würde. Auch würde sich nie ein Sehzentrum mit komplexen Funktionen bilden, wenn es nur einen Lichtrezeptor gibt.

M. Neukamm: Das „Lochkamera-Auge“ vieler höherer Wirbelloser war entstanden. Und erneut wurde die Evolution aus Gründen des Schutzes dazu „veranlaßt“, das Auge durch ein lichtdurchlässiges Häutchen zu schließen

Wie entsteht ein transparentes Häutchen? Entweder das Häutchen ist da oder es fehlt. Es kann sich nicht schrittweise bilden (und dabei jeweils einen Überlebensvorteil bringen). Hat es sich aus einem Häutchen gebildet, dass vorher eine andere Funktion hatte? Wenn ja, wie bildete sich dann jenes Häutchen und welches andere Häutchen erfüllt nun den Zweck, den das Häutchen vorher hatte? Das Stellen solch konkreter Fragen wird von Evolutionstheoretikern gern kritisiert. Das liegt wohl eher an der Unmöglichkeit, konkrete Antworten auf diese Fragen zu liefern, als an einer angeblichen Unzulässigkeit konkreter Fragen.

M. Neukamm: und es mit einer gallertartigen Substanz zu füllen.

Woher kommt diese Substanz? Wie wird sie gebildet? Woraus besteht sie? Woher „weiß“ diese Substanz, dass sie sich zwischen zwei transparenten Häutchen dergestallt einlagern muss, dass sich daraus eine Sammellinse entwickelt?

M. Neukamm: Wie nebenbei ergab sich so abermals eine Doppelfunktion, die die Möglichkeit zur Verbesserung der optischen Eigenschaften des Auges schuf, insbesondere zur Bildung einer Sammellinse, die dann Bildschärfe und Lichtstärke im Linsenauge der Wirbeltiere glücklich vereint. [Unterstreichungen von mir]

Das Problem der nichtreduzierbaren Komplexität wird hier einfach übergangen:

- Bildschärfe entsteht durch die Anzahl der Pixel eines Bildes. Gab es nur ein paar Photorezeptoren mit angeschlossenen Sehnerven, hätte weder die Lochblende noch eine Linse etwas gebracht (siehe Grafiken unten).

- Diese gallertartige Linse musste natürlich stets die exakte Linsenkrümmung aufweisen. Unregelmäßigkeiten hätten bereits den ganzen Aufwand zunichte gemacht.

- Die gallertartige Substanz musste so transparent wie möglich sein. Gleiches trifft auf die beiden postulierten Häutchen zu.

- Der Fokus musste exakt auf den Abstand zu den Photorezeptoren eingestellt sein.

- Die Photorezeptoren mussten alle den gleichen Abstand zur Linse aufweisen, was eine konkave Anordnung aller Rezeptoren auf der Innenfläche einer Kugel notwendig macht.

- Eine Linse benötigt im Gegensatz zu einem Loch einen Mechanismus der Reinigung.

- Ein Loch kann auch nicht verschmutzen, eintrüben oder verkratzen. Eine Linse braucht einen Schutz.

- Die angebliche gallertartige Substanz muss bei Landlebewesen durch eine weitere Vorkehrung vor Austrocknung bewahrt werden (Tränendrüsen, Tränenauslass, Tränenabfluss, Nervenzellen, die bei drohender Austrocknung einen Sinnesreiz an das zentrale Nervensystem senden, so dass die Absonderung von Tränenflüssigkeit eingeleitet wird, usw.).

- Ein Mechanismus zur Regulierung der Sehschärfe ist notwendig. Im Gegensatz zu einer Lochkamera benötigt eine Linsenkamera eine Möglichkeit der Fokusierung.

- Es muss die Fähigkeit entwickelt werden, scharfe Bilder von unscharfen zu unterschieden und das Auge auf Objekte unterschiedlicher Distanz zu fixieren.

| Dies ist das Ergebnis bei einer unscharfen Linse und 12 Fotorezeptoren. |

| Dies ist das Ergebnis bei einer scharfen Linse und 12 Fotorezeptoren. Die scharfe Linse bringt gegenüber der unscharfen Linse bei so wenigen Rezeptoren keinen Vorteil. |

| Die 41769 Photorezeptoren dieses Bildes sind völlig unnötig, da die Linse kein scharfes Bild liefert. Für Bildschärfe braucht man beides: eine genaue Optik und eine hohe Pixelzahl. |

| Hier haben wir eine hohe Pixelzahl und eine scharfe Linse, den richtigen Abstand zwischen Linse und Photorezeptoren, usw. Bei einem Fotoapparat ist die genaue Abstimmung der Optik natürlich auf die Intelligenz eines Designer zurückzuführen. |

Es lassen sich noch viele weitere notwendige Bestandteile eines funktionstüchtigen Linsenauges aufzählen, die alle gleichzeitig vorhanden sein mussten, damit ein Vorteil entstand, der das Auge vor der unbarmherzigen Selektion bewahrt.

M. Neukamm: Und dann müssen, wie von BLEULER und LÖNNIG suggeriert wird, weder Netzhaut, Glaskörper, Augenlinse und Hornhaut in einem Schritt entstehen, noch „optimal justiert zu sein“, denn die abgestuften Komplexitätsgrade des Auges innerhalb der rezenten Organismengruppen zeigen ja die stufenweise Emergenz der Einzelkomponenten, die jeweils verschiedene Funktionen erfüllt haben.

Nüchtern betrachtet handelt es sich nur um unterschiedliche Konstruktionen, die für das jeweilige Lebewesen und seinen Lebensraum optimal sind. Was sollte ein Wurm mit einem Linsenauge anfangen, wenn er in der Erde wühlt? Und was sollte eine Schnecke mit einem Adlerauge anfangen? Sie muss bestenfalls das Blatt sehen, dass sie gerade frisst. Könnte sie einen heraneilenden Igel gestochen scharf sehen, würde ihr das nichts nutzen, sie kann ja eh nicht mehr entkommen. Sie wäre nur einem unnötigen psychischen Druck ausgesetzt, bevor sie aufgefressen wird :·)

Was ist also von der Erklärung der allmählichen Entwicklung des Auges, wie Herr Neukamm sie schildert, zu halten? Diese Erklärung ist zweifelsohne der Phantasie entsprungen, was sicherlich auch niemand leugnen wird. Aber wie nennt man es, wenn jemand etwas behauptet, ohne etwas in der Hand zu haben? Das nennt man „Bluff“. Es gibt nicht eine einzige beweiskräftige Erklärung, die die Entwicklung eines der unzähligen nicht reduzierbar komplexen Systeme zufriedenstellend beschreiben könnte. Der systematische Erklärungsnotstand innerhalb der Evolutionstheorie und die Tatsache, dass nur intelligente Wesen in der Lage sind, nicht reduzierbar komplexe Systeme zu planen und zu konstruieren, macht Intelligent Design zu einer weit besser abgesicherten Erklärung als die Evolutionstheorie, und zwar für all diese Systeme.

Beim Thema „Auge“ möchte ich nicht versäumen, Sir Isaac Newton zu Wort kommen zu lassen, den Vater der Optik:

„Weshalb sind die Augen der verschiedensten Lebewesen durchgehend transparent? Warum ist das Auge das einzige transparente Körperorgan, das an der Außenseite eine feste durchsichtige Haut besitzt, innen eine transparente Flüssigkeit und in der Mitte eine kristalline Linse und eine Pupille vor der Linse – alles so vollendet geformt und für das Sehen konzipiert, dass kein Künstler sie besser hätte machen könnte? Wusste der blinde Zufall, dass es Licht gibt? Kannte er die Lichtbrechung? Konnte der Zufall die Augen aller Geschöpfe so wunderbar gestalten, dass sie ihren Zweck erfüllen konnten? Diese und ähnliche Überlegungen werden sich uns auch weiterhin aufdrängen, damit der Mensch glaubt, dass es ein Wesen gibt, das alle Dinge gemacht hat und das alles in seiner Gewalt hat und aus diesem Grund Ehrfurcht verdient.“ (Keynes Ms. 7 „A Short Scheme of the True Religion“ by Isaac Newton, Cambridge University Library, siehe auch Fußnote 1).

M. Neukamm: Auch vor der Entstehung des komplexen Flugapparates der Vögel waren fast alle Teilorgane grundsätzlich schon vorhanden, erfüllten aber andere Funktionen. So hat man bei fossilen Reptilien Protofedern gefunden, die offenbar der Wärmeisolation oder dem Balzerfolg dienlich waren. Darüber hinaus waren leichte, aber stabile Knochen, wie man sie ebenfalls bei solchen Theropoden nachgewiesen hat, auch für ein flugunfähiges Reptil nicht wertlos, denn sie erhöhen die Bodenschnelligkeit, erleichtern das Klettern, Fallen und könnten sich bei Luftsprüngen als vorteilhaft erweisen. Erst viel später mag sich herausgestellt haben, daß die Federn, der reptilienartige Schwanz und die Hohlknochen zusammengenommen einen primitiven Gleitflug ermöglichten, also Doppelfunktionen ausübten. (Diese und weitere Beispiele in VOLLMER, 1986, S. 23 ff.)

Auch zum Fliegen gehört mehr als nur Federn und leichte Knochen. Die Flugleistung der Vögel ist mit einer unglaublichen Rechenleistung ihres Gehirns verbunden. Die Koordination der Flugbewegungen, Steuerung, Reaktion auf unterschiedliche Luftströmungen sowie die Fähigkeit, zu starten und zu landen, lässt intelligente Flugzeugkonstrukteure nur staunen, ganz zu schweigen von verschiedenen Navigationssystemen zu Flugroutenbestimmung und Flughöhenregulierung. Außerdem hätte sich das Brutverhalten, Nestbaugewohnheiten, Nahrungsaufnahme und -beschaffung, Energiehaushalt, Kommunikationsverhalten, Blutkreislauf, Muskulatur, Skelett, Knochenaufhängung, usw. verändern müssen. Der Werdegang vom Ei bis zum ausgewachsenen Vogel unterscheidet sich grundlegend von demjenigen etwaiger Echsen (Weitere Einzelheiten siehe Junker/Scherer, Evolution – ein kritisches Lehrbuch, S.89, Kasten).

Dann bleibt noch die Frage nach der Entstehung des Instinkts. Durch Lernen entsteht kein Instinkt, da erworbene Fähigkeiten nicht vererbt werden können (Das Kind eines Pianisten kann nicht automatisch Klavier spielen – und jedes Kind muss eine Sprache neu lernen). Der Instinkt ist möglicherweise Bestandteil der DNS. Kann sich der Instinkt für Brutverhalten, Aufzucht der Jungen, Flugroutenberechnung, Flugsteuerung, usw. durch Defekte im DNS-Code bilden – und zwar zeitgleich mit den Defekten im DNS-Code, die angeblich aus Vorderbeinen Flügel und aus Schuppen Schwung-, Schwanz- und Steuerungs-Federn, usw. machen?

M. Neukamm: Wollten wir nun Evolution simulieren, wie müßte das entsprechende Modell dazu aussehen? Zunächst ist ein Mechanismus anzugeben, der Variationen erzeugt. Dann muß irgendeine Selektionsbedingung formuliert werden, die jede noch so kleine selektionspositive Veränderung fixiert. Diese Schritte sind solange zu wiederholen, bis man eine hinreichend komplexe Information in eine Struktur gebracht hat.

(Dieser Absatz erscheint zweimal hintereinander in Herrn Neukamms Dokument.)

Wenn es keine Reproduktion gibt, ist jede Mutation automatisch fixiert, aber eben nur für das mutierte Lebewesen. Der Ausdruck „Variationen“ impliziert wieder die Fähigkeit der Fortpflanzung, diese Fähigkeit muss aber erst einmal entstehen; und bis dahin muss Evolution auch ohne Selektion funktioniert haben. Aber wie?

Das veränderte Würfelbeispiel

M. Neukamm: Man denke sich beispielsweise einen Spieler, vor dem hundert Würfel ausgebreitet auf einem Tisch lägen. Nun bekäme er die Aufgabe, der Reihe nach solange mit jedem Würfel zu würfeln, bis er eine gerade Zahl erhielte und diesen Vorgang solange zu wiederholen, bis alle hundert Würfel eine gerade Augenzahl zeigen. Nachdem er schrittweise alle ungeraden Zahlen ausselektiert und die Zahlenreihe auf ein Blatt Papier geschrieben hat, läßt sich feststellen, daß die Wahrscheinlichkeit, die realisierte Zahlensequenz zu bekommen (1/6)100, also „fast Null“ beträgt. Der Auffassung des Evolutionsgegners entsprechend muß nun der Schluß gezogen werden, daß die Entstehung solcher Zahlenreihen „außerhalb des Bereichs der Wahrscheinlichkeit der sich auf unserer Erde abspielenden Zufallsprozesse“ liege.

Dieses Würfelbeispiel des Herrn Neukamm stellt die veränderte Variante seines ursprünglichen Würfelbeispiels dar. Es war nach dem Beispiel von Richard Dawkins (METHINKS IT IS LIKE A WEASEL) das zweite Mal, dass ich so richtig herzlich lachen konnte! Ich hoffe, Herr Neukamm nimmt mir das nicht für übel, aber, wenn man schon vorher weiß, was am Ende herauskommen soll (nämlich nur gerade Zahlen), dann kann eine intelligente Person natürlich entsprechend selektieren. Würde der Leser eine solche Zahlenreihe sehen, wäre ihm wohl sofort klar: Das ist das Ergebnis eines Algorithmus, und hinter einem Algorithmus steckt Intelligenz. Aber woher soll eine angenommene Selektion schon während des Aufbaus einer Struktur gewusst haben, wie diese aufgebaut werden muss, damit am Ende eine tauglichere Struktur herauskommt? Hier wird der Selektion Intelligenz unterstellt. Das Beispiel unterscheidet sich somit in der Grundannahme nicht von Richard Dawkins‘ kuriosem Beispiel. Auch er ging von einer intelligenten Selektion aus. Mich beschleicht das Gefühl, dass offenbar auch Evolutionstheoretiker nicht ganz ohne Intelligenz als Erklärung für Design auskommen!

Der Unterschied zwischen beiden Beispielen besteht darin, dass Richard Dawkins bei seinem Beispiel die Anzahl der Variationen auf Eins zusammenschrumpfte (entsprechend komplex ist der notwendige Algorithmus – die Wahrscheinlichkeit, dass das eine gewünschte Ergebnis am Ende herauskommt, beträgt 100%) und Herr Neukamm einen sehr simplen Algorithmus (If Zahl And 1 = 0 Then Gerade = True) zuhilfe nimmt, diese Einfachheit aber mit 5,15 · 1047 Variationen erkauft (Auch bei ihm beträgt die Wahrscheinlichkeit des Erreichens einer dieser 5,15 · 1047 Varianten 100%). So kommt es, dass Herr Neukamms Algorithmus keine Information mehr erzeugen kann (kann Richard Dawkins Beispiel ja eigentlich auch nicht – die Information muss ja in den Algorithmus einprogrammiert werden), sondern nur noch eine gewisse Ordnung liefert (z.B.: 2 – 6 – 4 – 4 – 2 – 2 – 6 – 2 – 6 – 4 – 2).

Jeder Mensch weiß aus Erfahrung, dass eine geordnete Struktur (und sei sie noch so rudimentär wie dieses Even-Odd-Beispiel, das sich wohl kaum noch vereinfachen lässt) eine ordnende Kraft (Gesetzmäßigkeit, z.B. ein Algorithmus) voraussetzt und jede Information eine kreative Kraft (Intelligenz). Die Selektion kennt natürlich keine Funktion wie If Zahl And 1 = 0 Then Gerade = True. Bei der Selektion geht es nur um eine einzige Zielsetzung: Alle untauglichen Lebewesen am Überleben hindern. Der Leser wird bemerkt haben, dass die Selektion nur greifen kann, wenn herausgefunden werden kann, ob eine schlechtere Tauglichkeit vorhanden ist. Dies kann man weder auf die einzelne Aminosäure noch auf ein einzelnes Nukleotid-Paar anwenden.

Außerdem ist mehr als ein geordneter Zustand nötig – am Ende soll eine Information entstehen! (Einzelheiten siehe: Ordnung ist nicht gleich Information). Man kann somit beim Aufbau einer DNS-Sequenz nicht für jedes Nukleotid-Paar feststellen, ob dieses tauglich ist – dazu müsste man ja wissen, welcher Aufbau am Ende herauskommen soll. Es ist die fertige Sequenz die funktional sein muss, nicht das Einzelteil. So wie die Frage, ob der Buchstabe „u“ richtig ist, nicht beantwortet werden kann, wenn man ihn nicht im Kontext betrachtet, so kann man dies auch nicht für einen isolierten genetischen Buchstaben. Adenin ist nicht tauglicher oder untauglicher als Cytosin. Die Selektion kann unmöglich wissen, welche genetischen Buchstaben akzeptiert und welche abgelehnt werden müssen, damit am Ende eine sinnvolle und damit funktionale Sequenz herauskommt. Erst ein gesamter Organismus kann ausselektiert werden.

M. Neukamm: Dieses Beispiel macht zweierlei deutlich: Erstens illustriert es anschaulich, daß man praktisch jedes Ereignis beliebig unwahrscheinlich rechnen und als nichrealisierbar ausgeben könnte. Tatsächlich lassen sich jedoch fast beliebig viele – wenn auch jedesmal verschiedene, niemals wieder dieselben – gleich unwahrscheinlichen Zahlenfolgen erwürfeln.

Das ist eine verdrehte Argumentation, wie sie mir bereits bei dem Dachziegelbeispiel begegnet ist. Jede Zahl beim Lotto hat die gleichen Gewinnchancen. Diese kann man mit 6 über 49 errechnen. Wenn die Lottozahl gezogen ist, so ist die Aussage: „Ich dachte, es ist fast unmöglich, diese Zahl zu ziehen, und doch wurde sie gezogen“ geradezu grotesk. Natürlich zieht die Lottofee jede Woche die „richtige“ Zahl. Nur, Lottozahlen enthalten doch keine Information. Aus einer Kiste mit Buchstaben eine Buchstabenfolge zu ziehen, die einen Sinn ergibt, das ist extrem gering. Die Chance irgendeine Buchstabenfolge zu ziehen ist natürlich 1:1. Dieses Axiom bedarf keiner Erklärung durch ein Beispiel.

M. Neukamm: Die Unwahrscheinlichkeit jeder einzelnen Konfiguration wird durch eine immens große Zahl an alternativen (potentiellen) Konfigurationsmöglichkeiten aufgewogen. (*)

Dies ist falsch! Die Anzahl sinnvoller informationstragender Sequenzen steht in keinem Verhältnis zu allen nur erdenklichen alternativen sinnlosen Sequenzfolgen. Von „aufgewogen“ kann keine Rede sein.

Um die Selektion richtig in dieses Würfelbeispiel zu integrieren, könnte es ungefähr so aussehen: Jemand würfelt eine Zahl und schreibt sie auf. Wenn es sich um eine ungerade Zahl handelt, so wird seine Sequenz verworfen und er muss ein neues Blatt nehmen, um von vorne zu beginnen. Wie lange wird es dauern, bis er 100 gerade Zahlen auf dem Blatt stehen hat? Wenn er es schafft, jede Sekunde einmal zu würfeln (die ungeraden Zahlen lassen wir dabei unberücksichtigt) benötigte eine Person das 3.631.669.772.337.866.642.965.084.910.125fache Erdzeitalter (angesetzt mit 4,5 Mrd. Jahren), um hundert gerade Zahlen auf seinem Blatt stehen zu haben. Dabei hat er noch keine Information erzeugt, sondern nur eine gewisse rudimentäre Ordnung. (Einzelheiten siehe: Ordnung ist nicht gleich Information). Eine Selektion kann beispielsweise ein kettenabschließendes Molekül nicht daran hindern, eine Molekülkette abzuschließen. Es müsste in diesem Fall die unvollständige Kette verworfen und von Vorne begonnen werden.

Diese für Evolutionstheoretiker äußert unangenehme Tatsache verleitet diese nun zu der Annahme, unbekannte Mechanismen, und eben nicht der Zufall, seien für den Aufbau komplexer Strukturen verantwortlich. Recht haben sie: Der ihnen unbekannte Mechanismus heißt: Intelligenz!

M. Neukamm: Zweitens wird gezeigt, daß sich im Rahmen selektionsgesteuerter Prozesse auch „informationstragende“ Strukturen mit einer vergleichsweise geringen Zahl an Versuchen erzeugen lassen. In Analogie zu dem Würfelbeispiel „spielt“ die Evolution gewissermaßen mit den Nucleotidbasen und Genen immer nur solange, bis irgendeine (!) beliebige adaptive Veränderung stattfindet, die positiv selektioniert und fixiert wird. Es steht dabei weder im Voraus fest, was geschaffen werden soll, noch daß Funktionalität völlig zufallsgesteuert oder gar in einem Schritt entstehen muß. An das jeweils Erreichte schließen sich weitere solcher Schritte an. Damit erreicht der Organismus stufenweise eine größere, spezifische Komplexität (und rückblickend auch einen „unwahrscheinlicheren“ Zustand).

Auf die Gefahr hin, mich zu wiederholen: Selektion kann nicht greifen, wenn es keine Reproduktion gibt (siehe auch Richtigstellung: Definition des Begriffes Selektion). Der Aufbau der ersten Lebensform, die sich reproduzieren konnte, hätte ohne Selektion auskommen müssen. Es kann nichts fixiert werden, was sich nicht irgendwie vermehren kann. Es müssen im ersten Lebewesen nicht nur alle notwendigen, funktionierenden, interagierenden Proteine entstanden sein, sondern auch noch gleichzeitig deren exaktes Abbild im genetischen Code. Dann muss eine Kopierfunktion vorhanden gewesen sein, die mit nahezu 100%iger Genauigkeit diesen Code reproduzieren kann, damit das einmal erreichte nicht sofort wieder zerfällt. Wenn Herr Neukamm also von „Nucleotidbasen und Genen“ spricht, dann setzt er bereits ein funktionsfähiges Lebewesen voraus. Klaus Wittlich betrachtete die Entstehung eines Bestandteils eines solchen Lebewesens, nicht dessen Veränderung.

M. Neukamm: SCHNEIDER hat in Simulationsversuchen genau das gezeigt: „Complex specified information“, die von Evolutionsgegnern wie beispielsweise DEMBSKI für einen Beweis eines „intelligenten Designs“ gehalten werden, läßt sich in solchen zweistufigen Prozessen völlig planlos generieren. Wie konnte er einen Zufallsgenerator dazu bringen, durch planlose Aneinanderreihung von Buchstaben „complex specified information“ zu erzeugen? Die Antwort gibt SCHNEIDER:

„By mutation (non directed, can’t be intelligent) replication (non-directed, can’t be intelligent) and selection (ahh ha!) (…) So what’s going on? Living things themselves create „specified complexity“ via environmental selections and mutations. Living things and their environment are the „intelligent designer“! So what was Dembski’s mistake? It was that he proposed that the design by necessity had to come from outside the living things, whereas it comes from within them and between the organism and its environment!„ (SCHNEIDER, 2002)

„Living things themselves create ’specified complexity'“. Bis hierher ist das die Aussage von Intelligent-Design-Theoretikern. „via environmental selections and mutations“ ist die Erklärung von Evolutionstheoretikern.

„Living things and their environment are the ‚intelligent designer'“! Das ist unsinnig, da immer noch nicht beantwortet ist, wo denn die „living things“ herkommen. Schneider setzt lebende Organismen einfach als gegeben voraus und argumentiert, dass diese lebenden Dinge sich dann selbst weiter designed hätten. Wie bildete sich aber das erste „living thing“ aus dem Leblosen? Selektion kann nur fertige (d.h.: funktionierende) Systeme verschonen.

Ein typisches Beispiel für Selektion in der Computerindustrie sind Roboter, die nach der Fertigung die Computerschaltkreise auf der Siliciumscheibe einer Funktionsprüfung unterziehen. Nicht funktionsfähige Chips werden markiert und anschließend ausselektiert. Fragt nun jemand: „Wie entstehen funktionsfähige Computerchips“, so wird ihm die Antwort: „Diese werden nicht ausselektiert“ wohl kaum befriedigen. Oder wie jemand es mal formulierte: „Wie kommen Blätter an die Bäume? Dadurch, dass der Gärtner sie nicht abgeschnitten hat“.

M. Neukamm: Im Hinblick auf die komplexen Genwechselwirkungen ist jedoch ein weiterer Faktor zu berücksichtigen, dessen Nichtbeachtung von Evolutionsgegnern in ein Argument gegen die Wahrscheinlichkeit transspezifischer Evolution gemünzt wird: Um alle Teilorgane zu einem komplizierten Baupläne zusammenzufügen, müssen – so der Einwand – mitunter dutzende oder gar hunderte von Genen derart miteinander verwoben und aufeinander abgestimmt sein, daß sie ein kompliziertes System aus Genwechselwirkungen (ein „epigenetisches System“) bilden. Es steht daher die Frage im Raume, wie infolge der Synorganisation, also der Verschaltung vieler Gene zu einem funktionellen Ganzen überhaupt noch sinnvolle Mutationen zustandekommen können, die gleichsam dem ganzen System einen Vorteil bescheren und positiv selektioniert werden. Es läßt sich zeigen, daß die „Verschaltung“ vieler einzelner Module (oder Gene) zu vermehrter Notwendigkeit, viele passende Mutationen zusammenzubekommen (letztlich also zu einer sinkenden Zahl an Anpassungsmöglichkeiten) führt.

Die eingangs erwähnten Autoren Junker und Scherer haben dieses Problem sehr anschaulich (wenn auch sehr stark zugunsten der Evolutionstheorie simplifiziert) am Beispiel eines Bakterienmotors veranschaulicht. Bei der Entstehung eines ersten reproduzierfähigen Lebewesens ist allerdings eine extreme Synorganisation gefordert, die, was ihre Komplexität angeht, nicht mehr zu überblicken ist. Alles, was zum Leben notwendig ist, musste gleichzeitig und am gleichen Ort entstehen und zu leben beginnen.

M. Neukamm: „Manche Apparate können durch sukzessive kleine Schritte entstehen: eine Stelle der Haut mit Lichtsinneszellen kann durch Pigmenthäufung zu einem Augenfleck werden. In einem zweiten Schritt wird der Augenfleck zu einem Napfauge, aber dieser zweite Schritt kann nicht richtungslos an einer beliebigen Stelle erfolgen, sondern ist an den Ort des Augenflecks gebunden. Dadurch wird die Wahrscheinlichkeit einer Weiterentwicklung zu einem Auge stark herabgesetzt, und das ist bei jedem weiteren Schritt der Fall, so daß die Wahrscheinlichkeit einer solchen Entwicklung äußerst gering wird.“ (REMANE et al., 1973, S. 160 f.)

Ich möchte an dieser Stelle noch einmal darauf aufmerksam machen, dass alle vorangehenden und alle nachfolgenden Absätze von bereits lebensfähigen Organismen ausgehen, um deren schrittweise Veränderung irgendwie mithilfe verschiedenster Hypothesen zu erklären. Die Entstehung dieser Organismen wird dabei nicht berücksichtigt, stellt jedoch die Kernfrage dar.

M. Neukamm: Wie also sind solche Kopplungen sowie die kooperativen, schrittweisen Umbauten ganzer Baupläne zu bewerkstelligen? Eine mögliche Antwort auf diese Frage liefern moderne Systemtheorien, die insbesondere von RIEDL ausgearbeitet wurden. In diesem Modell werden sukzessive Strukturgene unter ein Regulatorgen verschaltet. Beginnt man also mit einem solchen „Hauptschalter“ und einem neuartigen Funktionsprotein, können schrittweise weitere Gene unter die Kontrolle dieses Regulatorgens gebracht und ausprobiert werden, ob die Funktion besser wird (im Augenblick ist man im Falle des Komplexauges bei Drosophila bei 2000 Genen angelangt, die unter der Kontrolle von Pax6-Regulatorgens ausgeprägt werden)! Solche Einheiten „wachsen“ im Laufe der Zeit zu einem hierarchisch organisierten Gennetz, das sich immer schwerer auflösen läßt.

Wieder wird ein bereits reproduktionsfähiges Lebewesen vorausgesetzt. Aber wie ist es entstanden? Regulatorgene gibt es in einer Ursuppe mit Sicherheit nicht!

M. Neukamm: Eine Mutation am Regulatorgen würde nun eine Änderung des Zusammenspiels aller untergeordneten Gene gleichzeitig bewirken. Die einzelnen Strukturen, die beim Aufbau eines Organs beteiligt sind, müßten infolge der Kopplung nun nicht mehr „warten“, bis die anderen „richtig“ mutieren. Dadurch wird die Trefferchance für eine günstige Mutation stark erhöht, weil das Variationspotential mit steigendem Kopplungsgrad dramatisch eingeengt wird (man könnte sagen, die „Loszahl“ der möglichen Mutationen wird durch Kopplung bedeutend verringert) (RIEDL, 1990).

Wie entstand das erste Lebewesen? Das ist die Frage. Und nicht: Wie verändert sich ein bereits bestehendes Lebewesen?

M. Neukamm: Denken wir uns dazu eine Struktur, für die zehn Gene codieren. Nehmen wir an, die Chance, daß in jedem der zehn ungekoppelten Gene unabhängig voneinander eine passende Mutation zustandekommt, läge jeweils bei 10-6. Die Wahrscheinlichkeit einer positiven Gesamtveränderung der Struktur erniedrigt sich daher auf (10-6)10 = 10-60. Kommt es nun aber zu einer „Rangung“ (Ordnung) der zehn Gene im Sinne einer gemeinsamen Kopplung unter ein Regulatorgen, können viele der Einzelentscheidungen (Mutationen) vermieden werden, wir haben es mit einem Abbau von „redundanten Determinationsentscheidungen“ zu tun. Infolge der Kopplung zehner Gene beträgt die Chance, das Funktionselement als Ganzes selektionspositiv zu verändern, jetzt nicht mehr 10-60 – die Erfolgschance der Änderung eines Regulatorgens bleibt im Prinzip bei 10-6 (RIEDL und KRALL, 1994). Und da es immens viele Möglichkeiten geben dürfte, irgendwelche Gene schrittweise so zu verschalten, daß sie dem System jeweils einen Überlebensvorteil bescheren, ist die Schlußfolgerung der Evolutionsgegner widerlegt.

Wir können also festhalten: Die Kopplung von Genen führt einerseits zwar zu einer höheren Notwendigkeit, „passende“ Mutationen zusammenzubekommen; aufgrund der Folgelasten wächst der „selektive Ausschuß“. Gleichzeitig wird aber das Evolutionsgeschehen immer mehr dem Regime des Zufalls entzogen.

Das Wort „Zufall“ ist Evolutionstheoretikern fraglos äußerst unangenehm. Es wird daher vehement nach Möglichkeiten gesucht, die Mutationen der Gewalt des Zufalls zu entreißen. Man bemüht dazu alle nur denkbaren Hypothesen. Letztlich ist die Entstehung des ersten Lebewesens aber entweder durch reinen Zufall entstanden oder durch intelligentes Wirken. Selektion müsste sich zu diesem frühen Zeitpunkt vor allem auf den Zweite Hauptsatz der Thermodynamik beschränken. Langkettige Moleküle halten dem Zerfall (als Ergebnis der Entropie) nicht stand, wenn sie nicht Teil eines Systems (z.B. einer Zelle) sind, das diesem Zerfall standzuhalten in der Lage ist und es keinen Mechanismus der gezielten Herstellung (bzw. Reproduktion) lebensnotwendiger Makromoleküle gibt.

M. Neukamm: Die Biologen sprechen von „Kanalisierung“ oder Entwicklungszwängen („constraints“) (ALBERCH, 1982). Damit wird jedoch jede Wahrscheinlichkeitsbetrachtung wertlos, weil die Prämisse von der Kumulation vieler unabhängiger Mutationsschritte nicht mehr stimmt:

Für die Entstehung erster DNS-Sequenzen ist dies irrelevant. Die Entstehung geschieht ohne Mutation durch einfache Aneinanderkettung von Nukleotiden.

M. Neukamm: „Dabei (inzuge der Genkopplung) zieht das Wachsen bestimmter Notwendigkeiten einen Abbau der Möglichkeiten des Zufalls nach sich, während dieses verringerte Repertoire der Entscheidungen eine Kanalisation der möglichen Ereignisse zur Folge hat (…) Die funktionelle Bürde vieler Merkmale und der selektive Ausschuß wachsen. Gleichzeitig aber werden im Fall gleichbleibender Anpassungsziele zahlreiche Entscheidungen redundant (…) Der Anpassungsvorteil steigt dabei exponentiell mit der Zahl der vermeidbaren Entscheidungen, wobei die Zunahme der Realisierungschancen eines bestimmten Zustandes wieder der Abnahme der Möglichkeiten des Zufalls entspricht (…)“ (RIEDL, 1990, S. 352 f.)

Zusammenfassend läßt sich feststellen, daß die Wahrscheinlichkeitsberechnungen nicht das leisten, was sich Antievolutionisten erhoffen. Die angenommenen Voraussetzungen erweisen sich als falsch, weil sich Berechnungen, welche die Selektion, die Entscheidungsfreiheit in der Evolution, die Möglichkeit von der Existenz von Doppelfunktionen, oder die Kopplung von Genen unberücksichtigt lassen, als irrelevant herausstellen.

- Selektion kann bei der Entstehung des ersten reproduktionsfähigen Lebewesens nicht greifen.

- Entscheidungsfreiheit haben nur intelligente Wesen, Naturgesetze nicht.

- Doppelfunktionen Die Entstehung einer Struktur, die mehrere Funktionen ausführt, ist natürlich noch weit unwahrscheinlicher, als die Entstehung einer Struktur, die nur eine einzige Funktion hat.

- Genkopplung verkompliziert die zufällige Entstehung eines ersten Lebewesens und bringt dort nichts.

Tatsächlich ist keine der angeführten Punkte von irgendeiner Relevanz, wenn es um die Entstehung eines ersten Lebewesens aus „toter“ Materie geht. Aber selbst wenn man ein erstes Lebewesen einfach als vorhanden voraussetzt (wie Darwin das vor den Tatsachen kapitulierend tat), können obige Mechanismen die Vielfalt an Lebewesen nicht erklären. Selektion wirkt veränderungshemmend. Evolution hat keine Entscheidungsfreiheit, sondern existiert empirisch zugänglich nur im Rahmen einer auf Dauer gesehen degenerierenden Mikroevolution. Eine Höherentwicklung ist eine unzulässige Extrapolation aus allmählicher Abwärtsentwicklung. Doppelfunktionen müssen, wie der Name schon andeutet, mindestens zwei Funktionen gleichzeitig ausführen können. Die Entstehung solcher Doppelfunktionen ist logischerweise unwahrscheinlicher als die Entstehung von Einfachfunktionen.

Letztendlich bringen alle hier vorgebrachten Erklärungsversuche neue Probleme, statt die bestehenden Probleme der Evolutionstheorie zu beseitigen oder zu verringern: Ohne Selektion wäre eine Evolution ungerichtet (und so eine Evolution braucht man nicht), mit Selektion wird Evolution andererseits stark behindert (um nicht zu sagen: verhindert). Mutationen sowie Kopierfehler werden zwar als grundsätzlich negativ angesehen, aber ohne sie gäbe es überhaupt keine Veränderungen. Doppelfunktionen verringern das Problem der Synorganisation zwar ein wenig, potenzieren jedoch die Unwahrscheinlichkeit ihrer Entstehung. Es ist so wie Junker und Scherer es in ihrem Kritischen Lehrbuch treffend formulieren:

Die Einbeziehung innerer Selektionswirkungen [z.B.: Genkopplung, Anm. von mir] ist zwar sicher eine theoretische Notwendigkeit, aber in dieser Theorie einer evolutiven Entstehung neuer Strukturen werden ebensoviele neue Probleme aufgeworfen wie alte als gelöst angesehen werden. […] Den Erklärungsversuchen für Makroevolution durch „Präadaption“, „additive Typogenese“ und „Doppelfunktionen“ gelingt nur eine „Verkleinerung“ der Problematik, sie können jedoch keine Lösungen anbieten (S. 93).

Fazit:

„Leben kommt nur aus Leben“. Dieser Satz, von Louis Pasteur geprägt, hat ewige Gültigkeit. In seinem hier besprochenen Artikel setzt Herr Neukamm sowie viele andere Evolutionstheoretiker diese Wahrheit stillschweigend voraus, denn sie reduzieren Evolution auf Veränderung und Selektion in bereits lebenden und sich reproduzierenden Lebensformen. Wie das erste Lebewesen aber entstanden sein soll, dazu „hört“ man nur betretenes Schweigen.

Dass die den Evolutionstheoretikern so verhasste Wahrscheinlichkeitsrechnung sehr wohl auf die Entstehung von Makromolekülen anwendbar ist, wird in dem Artikel Ist die zufällige Entstehung informationstragender Makromoleküle möglich? ausführlich erklärt. Wenn sich keine Makromoleküle (wie die DNS) von selbst bilden können, dann ist es müßig, darüber nachzudenken, ob und wie sich ein erstes Lebewesen von selbst bilden könnte und wie sich dieses Lebewesen zu dem Formenreichtum der uns umgebenden Welt entwickelt hat. Wenn der erste Schritt gar nicht möglich ist, braucht man über Schritt 2 und 3 (die von Schritt 1 abhängen) nicht zu spekulieren. Im Gegenteil: Wenn die Herstellung eines informationstragenden Makromoleküls einen intelligenten Designer voraussetzt, dann kann man sich auch vollständig über das von Evolutionstheoretikern erlassene Denkverbot hinwegsetzen und einen intelligenten Designer als Ursache für die gesamte Artenvielfalt akzeptieren.

Was soll man aber von einer Theorie halten, der die Voraussetzungen völlig fehlen? Kann etwa ein Computervirus von selbst entstehen? Die Tatsache, dass es sich fortpflanzen und rasant vermehren kann und durch Störungen auf magnetischen Datenträgern auch Veränderungen erfahren kann, ist keine Erklärung für seine Entstehung. Mir ist kein Computervirus bekannt, das nicht von einem intelligenten Designer stammt. Mir sind aber tausende bekannt (ein Blick in mein Virenlexikon genügt), die allesamt von intelligenten Programmierern stammen. Warum sollte ich annehmen, das erste Computervirus sei von selbst entstanden, und alle anderen hätten sich im Laufe der Zeit durch Mutationen entwickelt, zumal die Geschichte der Entstehung des ersten Computervirus schriftlich überliefert wurde (TIME, Ausgabe 26. September 1988, S. 44, Kasten „You Must Be Punished“).

Diese schriftliche Überlieferung als abergläubischen (religiösen) Irrwahn hinzustellen, zeugt von mangelnder Sachkenntnis. Ein Programmierer sei ein Lückenbüßer und erkläre im Grunde nichts, da man mit ihm jedes Programm erklären könne – das sind die Argumente der Evolutionstheoretiker in Bezug auf einen intelligenten Designer, der für die Entstehung des Lebens verantwortlich ist (siehe dazu auch meinen Kommentar zu dem Kritikpunkt 8).

Wie sieht die Alternative für Intelligent-Design, nämlich Evolution aus? Liefert sie befriedigende Antworten? Sind die Erklärungsversuche in Übereinstimmung mit wissenschaftlichen Erkenntnissen? Bei näherer Betrachtung stellt man fest: Das Gegenteil ist der Fall! Darwin extrapolierte von Varietäten innerhalb einer Art (Mikroevolution) bei Finken und Hunden auf Veränderungen, die zu neuer Artenbildung führen (Makroevolution). Heute weiß man: Aus einem Wolf kann man einen Dackel züchten; aber aus einem Dackel keinen Wolf. Der Wolf hat den reichen Genpool, der Variationen zulässt; der Dackel mit seinem ausgedünnten Genpool kann durch Züchtung nicht mehr entscheidend verändert werden. Der Genpool kann zwar ausgedünnt werden (durch Inzucht sogar mit größerem Tempo), aber Gen-Informationen, die einmal definitiv verloren sind, können durch kein Naturgesetz wieder angereichert und aufgebaut werden. Was könnte die Evolutionstheorie Darwins also retten? Neodarwinisten hatten die Antwort: Der Zufall (Mutationen) in Zusammenarbeit mit diversen Genverlängerungs-Hypothesen. Je mehr wir über den komplexen Aufbau der Gene erfahren, umso unplausibler wird der Zufall als Erklärung für den Aufbau komplexer Information.

Man könnte meinen, nun seien Neodarwinisten am Ende. Dies ist jedoch nicht der Fall! Sie haben ihre Aussagen vielmehr bis in alle Ewigkeit gegen jeden Angriff immunisiert: Zukünftige Entdeckungen sollen beweisen, dass Evolution doch funktioniert. Die vielen Wissenslücken würden sich noch schließen und die vielen Gegenbeweise würden damit ungültig gemacht werden. Auf dieser erhofften zukünftigen Grundlage wird weiter geforscht. Diese Art der Argumentation kann natürlich auch als Kapitulation vor der erdrückenden Beweislast gewertet werden und als Eingeständnis der Unfähigkeit, die geforderten Beweise für die Richtigkeit der Evolutionstheorie zu liefern. Der einzige „Beweis“ für eine Evolution ist und bleibt deren angebliche Notwendigkeit, wenn man einen intelligenten Designer als Erklärung von vornherein ausschließt.

Bruno Vollmert: Es ist auch mein Eindruck, daß die Furcht vor der Alternative – dem göttlichen Plan – uns heute in Gefahr bringt, die Augen vor wissenschaftlichen Fakten zu verschließen: nicht wissen zu wollen, was DARWIN nicht wissen konnte. (Das Molekül und das Leben, S.27)

Ergänzungen:

- 30.03.2003:

Meine Anmerkungen wurden in das Dokument Richtigstellungen ausgelagert. - 26.03.2004:

Was Herr Neukamm zu meiner Verteidigung der Wahrscheinlichkeitsrechnung schreibt, findet der interessierte Leser hier

Fußnoten:

- Der Text im Original lautet: „Whence is it that the eyes of all sorts of living creatures are transparent to the very bottom & the only transparent members in the body, having on the outside an hard transparent skin, & within transparent juices with a crystalline Lens in the middle & a pupil before the Lens all of them so truly shaped & fitted for vision, that no Artist can mend them?

Did blind chance know that there was light & what was its refraction & fit the eyes of all creatures after the most curious manner to make use of it?

These & such like considerations always have & ever will prevail with mankind to believe that there is a being who made all things & has all things in his power & who is therefore to be feared.“ (siehe The Newton Project)